2025 年构建生产级 RAG 系统:从 Demo 到企业级实战

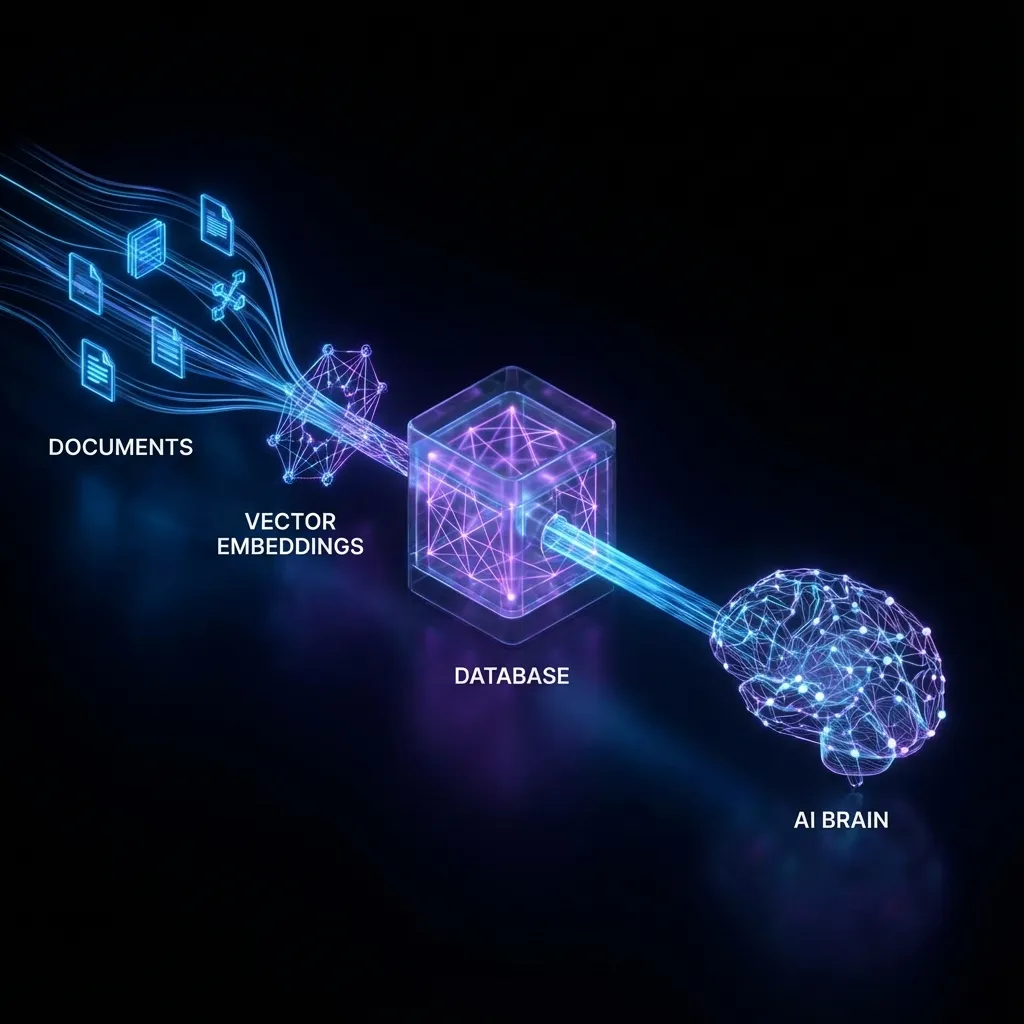

过去一年,检索增强生成 (RAG) 迅速从一个新颖的学术概念演变为企业 AI 应用落地的标准架构。对于今天的开发者来说,用 LangChain 或 LlamaIndex 写一个几十行代码的基础 RAG Demo 简直易如反掌:丢进去一个 PDF,切一切,存进向量库,然后用 ChatGPT 回答问题。

但当你试图把这个 Demo 推向生产环境,尤其是面对企业文档中复杂的格式和晦涩的内容时,噩梦才真正开始。高幻觉率、检索内容看似相关实则无用、过高的首字延迟 (TTFT)——这些问题构成了所谓的“RAG 鸿沟”。

想要跨越这道鸿沟,我们需要极度精细的工程手段。本文总结了基于 2025 年技术栈构建生产级 RAG 系统的实战经验。这不仅仅是关于选择哪个 LLM,更是关于如何构建高质量的数据管道。

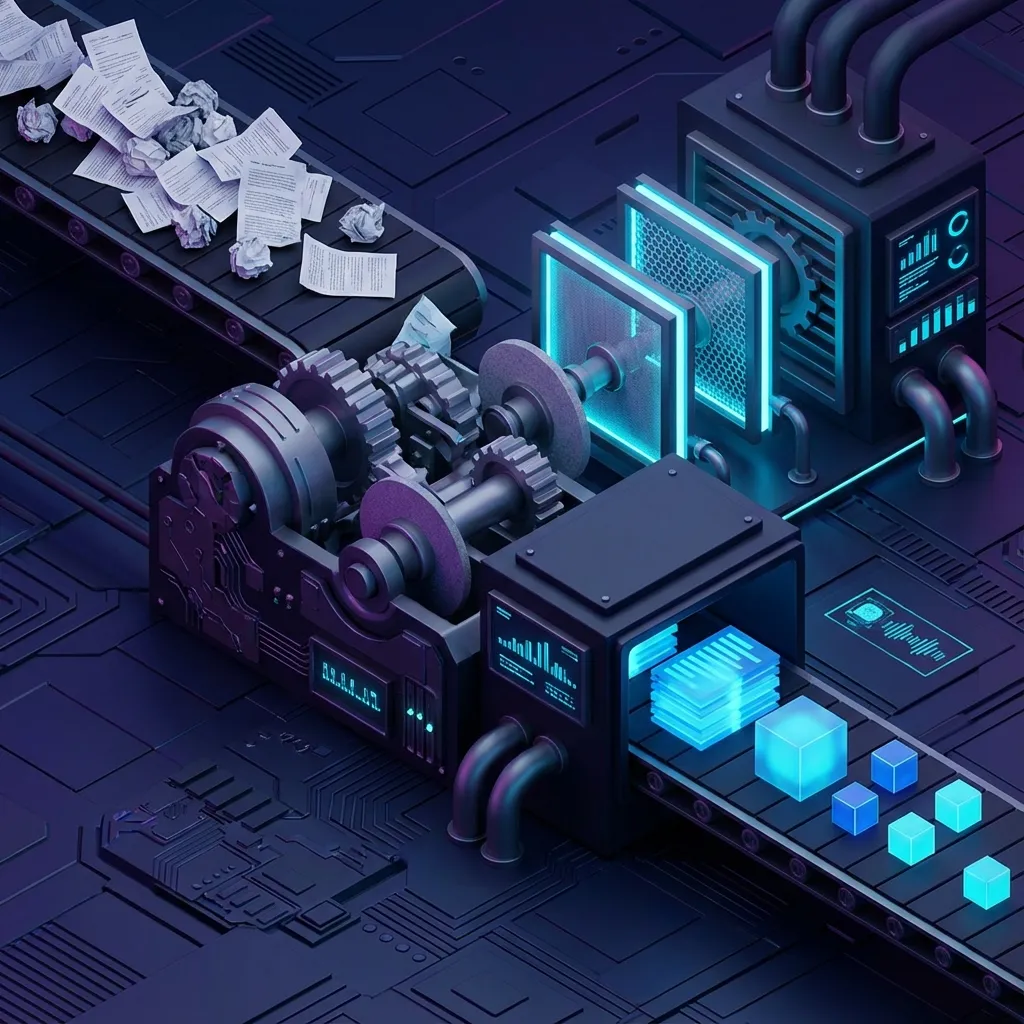

1. Garbage In, Garbage Out:数据清洗是 RAG 的灵魂

在 RAG 系统中,检索 (Retrieval) 的质量决定了生成 (Generation) 的上限。而检索质量的基石在于数据。很多开发者花大把时间微调 Embedding 模型,却忽略了最基础的环节:数据质量。

生产环境的数据永远不是整齐划一的 Markdown。你面对的是扫描版 PDF、乱七八糟的 PPT、包含页眉页脚的 Word 文档,甚至是带着复杂表格 Excel 文件。

PDF 解析的痛点与解法

普通的 Python 库(如 PyPDF2)只能提取线性文本流。它们会无情地打碎表格、混淆双栏排版的内容,甚至把页码当成正文提取出来。

2025 最佳实践:

- 使用视觉大模型解析 (Vision-Language Models):对于复杂的扫描件或图表,传统的 OCR 已经不够用了。现在的趋势是使用 GPT-4o 或专门的解析模型(如 LlamaParse, Unstructured)来理解页面布局。

- 表格还原:表格是 RAG 的阿喀琉斯之踵。如果不做特殊处理,表格数据被展平后完全丢失语义。你需要将表格转换为 Markdown 表格格式,甚至在 Embedding 之前先将其概括为自然语言描述。

元数据的黄金价值

不要只存文本!在分块 (Chunking) 之前,必须尽可能多地提取元数据 (Metadata)。

- 层级结构:这个 Chunk 属于哪个 H1 标题?哪个 H2 标题?

- 时效性:文档的发布日期。

- 业务属性:适用部门、保密等级、相关产品线。

这些元数据的首要用途是 预过滤 (Pre-filtering)。在进行向量检索之前,先通过 SQL 语句缩小搜索范围(例如 WHERE department = 'HR' AND year > 2023)。这不仅能大幅减少噪声,还能顺便解决权限控制问题——你肯定不希望普通员工搜到 CEO 的薪酬方案。元数据隔离是最安全的做法。

2. 智能分块:告别机械切割

RecursiveCharacterTextSplitter 是大多数人的入门选择。它设定一个固定字数(比如 500 或 1000),然后机械地切分。这种做法在生产环境往往是灾难性的。

想象一句关键逻辑:“如果用户欠费超过 30 天,则……(切断)……停止服务并发送律师函。” 如果恰好切在“则”字后面,检索时可能只召回了后半段,LLM 可能会产生极度危险的幻觉,认为只要欠费就该发律师函。

语义分块 (Semantic Chunking)

2025 年的主流方案是放弃固定长度,拥抱 语义分块。 原理是:利用 Embedding 模型计算相邻句子的相似度。

- 遍历文档所有句子。

- 计算第 N 句和第 N+1 句的向量余弦相似度。

- 如果相似度突然骤降(说明话题转换了),就在这里切一刀。

这样切出来的每个 Chunk 都是语义完整的一个段落,检索准确率大幅提升。

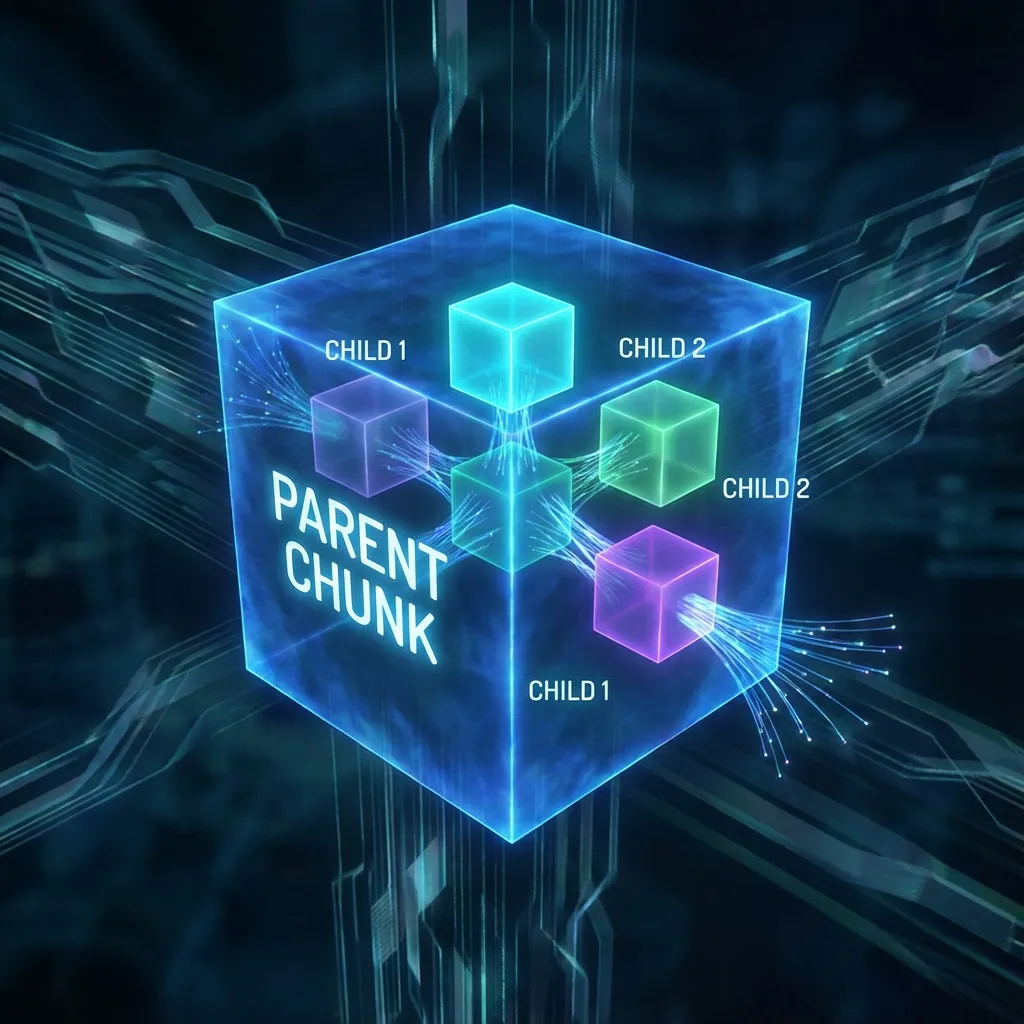

父子索引 (Parent-Child Indexing / Small-to-Big)

这是一个非常有效但常被忽视的策略,它解决了“检索粒度”和“生成上下文”之间的矛盾。

- 检索粒度:为了精准匹配,我们需要 Chunk 尽可能小(比如一两句话),向量更聚焦。

- 生成上下文:为了 LLM 回答全面,我们需要 Chunk 尽可能大(包含前因后果)。

解法:

- 将文档切分 父块 (Parent Chunks)(比如 2000 token 的大段落)。

- 将每个父块再切分为 子块 (Child Chunks)(比如 200 token 的小碎片)。

- 只对子块做向量索引。

- 当检索命中子块时,将其所属的父块 (Parent Chunk) 召回给 LLM。

这样既保留了检索的锐度,又给了 LLM 完整的上下文窗口。

3. 混合检索:向量不是银弹

纯向量检索 (Dense Retrieval) 强在匹配抽象语义,比如用“网络断了”去搜“检查路由器设置”。但在匹配专有名词、精确数值或代码片段时,它往往不如传统的关键词检索。

不信你试着在向量库里搜一个具体的错误码(如 “Error 0x80042109”)或者某个具体的 SKU 编号。向量检索很可能给你找回来一堆关于“未知错误”的文档,而不是包含那个确切代码的文档。

生产级系统必须使用混合检索 (Hybrid Search):

- Dense Retrieval:使用 Embedding 模型(如 OpenAI text-embedding-3-small 或 BGE-M3)做向量相似度搜索。

- Sparse Retrieval:维护一套基于 BM25 算法的倒排索引,专门做关键词匹配。

- RRF 融合 (Reciprocal Rank Fusion):将两路检索结果进行去重和排序融合。

RRF 算法非常简单有效: $$ Score(d) = \sum \frac{1}{K + rank(d)} $$ 它不依赖绝对的分数值,只看排名。这完美解决了向量距离和 BM25 分数维度不一致的问题。

4. 重排序 (Re-ranking):最后一道防线

通常我们会设置 Retrieve Top K 为 20 甚至 50,因为我们希望召回率 (Recall) 尽可能高——宁可抓错,不可放过。 但如果直接把这 50 个 Chunk 塞给 LLM:

- Token 消耗巨大:成本飙升,速度变慢。

- Lost in the Middle:研究表明 LLM 对 Context 中间位置的信息关注度较低。关键信息被淹没在噪声中,反而会导致幻觉。

引入 Cross-Encoder 重排序模型 是性价比最高的提效手段。 Retrieval 得到的是基于 Bi-Encoder 的粗略相似度。而 Rerank 模型(如 Cohere Rerank 或 BGE-Reranker)会将 Query 和每一个 Document 拼接在一起进行深度的语义交互计算,给出一个极高精度的相关性打分。

Pipeline 设计:

- 混合检索初步召回 50 个文档。

- Rerank 模型对这 50 个打分。

- 设定阈值(如 score > 0.7),截断不相关的,只保留 Top 5 给 LLM。

虽然 Rerank 增加了几百毫秒的延迟,但它对最终 RAG 效果的提升是决定性的。

5. 持续评估:拒绝“体感”

如果你还在靠“问几个问题看看回答好不好”来评估你的 RAG 系统,那你永远无法科学地迭代。当你修改了一个分块参数,可能修好了这个问题,却搞坏了另外十个。

你需要建立自动化的评估管道 (RAGOps):

- 黄金数据集 (Golden Dataset):这就像软件测试中的 Test Cases。你需要人工标注 50-100 个具有代表性的 QA 对(Query + Ground Truth Answer + Context)。

- 自动打分系统:使用 Ragas 或 TruLens 等框架。它们利用 GPT-4 作为法官 (Judge) 来计算核心指标:

- Context Precision:召回的 Chunk 里真的包含答案吗?

- Faithfulness:生成的回答是基于 Context 的,还是 LLM 瞎编的?

- Answer Relevance:回答是否直面用户的问题?

每次代码提交或参数调整,都必须跑一遍自动化回归测试,确保指标没有下跌,才能上线。

总结

构建生产级 RAG 没有银弹,它是一场工程细节的战争。从数据清洗的脏活累活,到混合检索的算法调优,再到 RAGOps 的体系建设,每一个环节都扣着最终的体验。

不要盲目崇拜更大的模型,先修好你的数据管道。2025 年,Data Engineering is the new Prompt Engineering。